Focus op AI bij de rijksoverheid

De rijksoverheid weet van veel kunstmatige intelligentie (AI) niet of die naar behoren werkt. Voor meer dan de helft van de AI-systemen die het Rijk gebruikt, zeggen overheidsorganisaties dat de kansen nog niet zijn afgewogen tegen eventuele risico’s. Bovendien is er een prikkel om risico’s laag in te schatten. Dat blijkt uit een focusonderzoek van de Algemene Rekenkamer onder 70 overheidsorganisaties.

Die 70 organisaties hebben bij elkaar 433 AI-systemen opgegeven. Het gebruik van AI binnen het Rijk is nog niet erg wijdverbreid: De meeste systemen (167) zijn nog lopende experimenten, en veruit de meeste organisaties (88%) geven aan niet meer dan 3 AI-systemen te gebruiken. Slechts 5% van de systemen is te vinden in het openbaar algoritmeregister. De organisaties die het meest gebruik maken van AI zijn de politie en het UWV. Zij gebruiken respectievelijk 23 en 10 AI-systemen. Het onderzoek van de Rekenkamer geeft voor het eerst inzicht in hoeveel AI het Rijk gebruikt en waarvoor.

Vooral gericht op interne processen

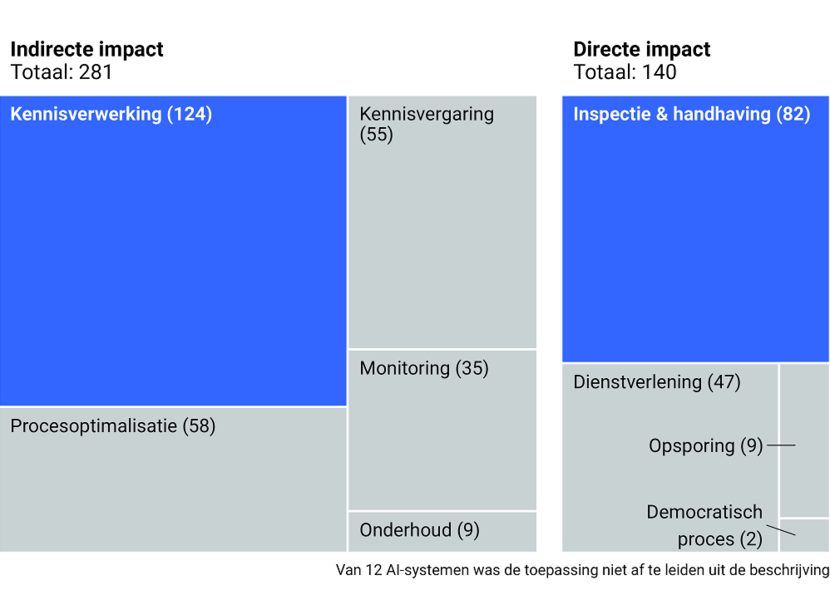

Zo’n twee derde van alle systemen is gericht op interne processen die niet direct impact hebben op burgers en bedrijven, zoals het doorzoeken en verwerken van grote hoeveelheden informatie om processen te optimaliseren. Door AI die bijvoorbeeld gesprekken automatisch omzet naar tekst, of documenten in een handomdraai kan anonimiseren, kan de overheid veel tijd en geld besparen. Ook kost het doorzoeken van interne documenten aanzienlijk minder moeite dan wanneer ambtenaren dat handmatig moeten doen.

AI wordt veel toegepast voor inspectie, handhaving en kennisverwerking

Prestaties onbekend

Het valt op dat organisaties vaak niet weten of de AI-systemen die zij gebruiken naar behoren presteren. Bij 35% van de systemen die in gebruik zijn, is niet bekend of het AI-systeem de verwachting waarmaakt. Dat gebeurt bijvoorbeeld wanneer niet van tevoren is bepaald wat het doel is, of wanneer het systeem een succes is. Wat ook opvalt, is dat organisaties vaak positief zijn over de AI-systemen die zij niet meer in gebruik hebben. 82 van de 141 beëindigde AI-systemen (58%) presteert volgens de organisaties naar verwachting of zelfs beter. Dat ze toch worden beëindigd komt dan bijvoorbeeld door een gebrek aan capaciteit om ze verder te ontwikkelen.

Risico’s verschillen per systeem

Het gebruik van AI biedt kansen, maar er zijn ook risico’s. Die worden deels ondervangen met een nieuwe Europese AI-verordening. Onder de nieuwe regels moeten alle AI-systemen worden beoordeeld op risico’s. Een systeem dat toeslagen regelt voor kwetsbare huishoudens is bijvoorbeeld risicovoller dan AI die gebruikt wordt om snel ambtelijke teksten te kunnen samenvatten. Kunstmatige intelligentiesystemen met onaanvaardbare risico’s moeten gestopt worden, systemen met een hoog risico moeten in de toekomst aan extra voorwaarden voldoen. Organisaties classificeerden het risico bij de meeste AI als ‘minimaal’. Dat betekent echter niet dat deze systemen ook echt risicovrij zijn. Het gaat dan bijvoorbeeld om mogelijke privacyschending, slechte informatiebeveiliging of een mogelijk negatieve impact op burgers en bedrijven, bijvoorbeeld als gevolg van oneerlijke vooroordelen.